Quando se trata dos assistentes de voz, há quem prefira a Alexa, Google Assistente ou Siri. Apesar de cada um trazer suas próprias qualidades, a empresa focada em treinamento de inteligência artificial Bespoken, dos Estados Unidos, testou os três assistentes para saber qual deles é o melhor para responder perguntas simples e complexas.

Para realizar o teste, a empresa usou um Amazon Echo Show 5 (Alexa), Apple iPad Mini (Apple) e um Google Nest Home Hub (Google Assistente). Além disso, quem realizou os testes foi um robô da Bespoken, capaz de imitar a fala humana, fazendo perguntas dos seguintes tópicos: Geografia, História, Música, Cinema, Política e Esportes.

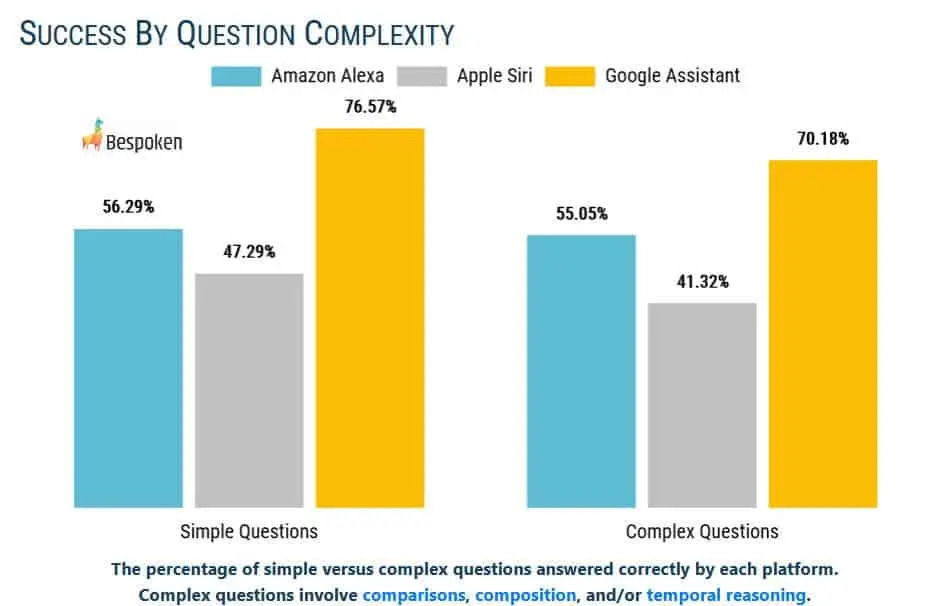

Durante a avaliação, o Google Assistente liderou em todos os tipos de respostas, acertando 76,57% das perguntas simples e 70,18% das perguntas complexas. Em seguida vem a Alexa, com 56,29% de acerto para perguntas simples e 55,05% para as complexas. Em último lugar ficou a Siri, respondendo corretamente apenas 47,29% das perguntas simples e 41,32% das complexas.

Na média geral, o Google Assistente fica em primeiro lugar no número de respostas bem-sucedidas, acertando 73,19% das vezes. Em segundo vem a Alexa, com 55,38%, e, por último, a Siri, com 43,17% de acertos.

De acordo com o chefe da Bespoken, Evangelist Emerson Sklar, apesar da liderança do Google Assistente, todos os assistentes de voz são capazes de melhorar.

“Os resultados destacam que os desenvolvedores precisam testar, treinar e otimizar intensivamente os apps que criam para essas plataformas de voz (…) Nosso processo foi completamente automatizado, e pretendemos continuar com esses testes, além de introduzir novas marcas de referência”, diz o chefe da Bespoken.

A Bespoken conclui dizendo que as respostas erradas não estão relacionadas, necessariamente, com a dificuldade na compreensão, mas com a inexistência da informação no banco de dados.