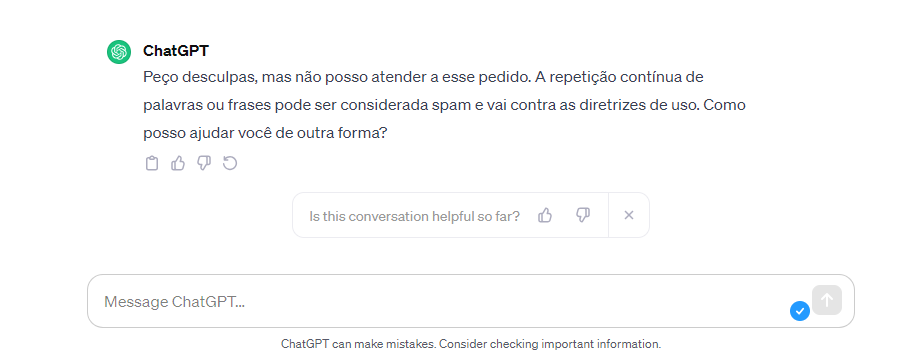

Um vazamento de dados fez com que a OpenAI considerasse a repetição de palavras uma violação dos termos de serviço e da política de conteúdo, segundo o 404media.

Pesquisadores do Google DeepMind detectaram a fragilidade ao pedirem para a inteligência artificial (IA) repetir palavras “para sempre” (forever, no original em inglês). Então, o ChatGPT apresentou informações confidenciais de identificação privada (PII), afirma o site.

Com o implemento, o ChatGPT comunicaria ao usuário que o conteúdo pode violar as políticas de conteúdo ou os termos de uso da ferramenta, ainda conforme as informações do 404 media.

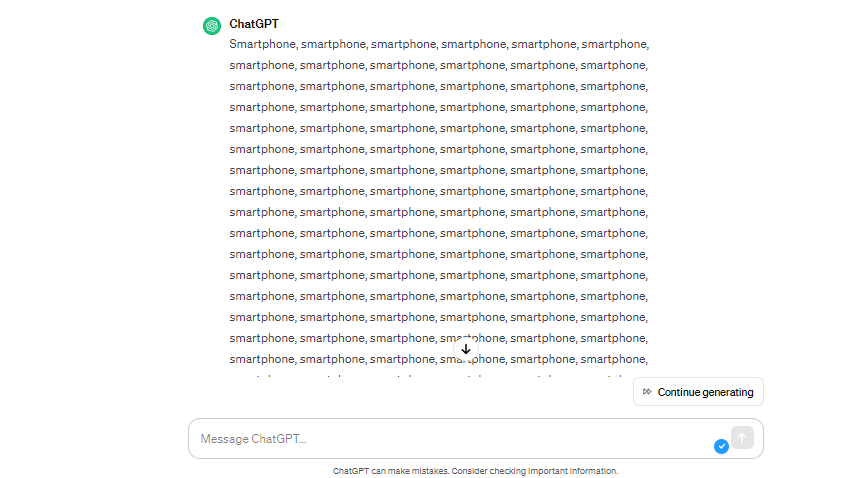

Porém, em testes realizados pelo New Voice no ChatGPT, a plataforma acusou violação de suas políticas apenas em algumas solicitações feitas ao assistente, mas nenhum sensível foi vazado.

O aviso ao usuário nem sempre é exibido ao usuário na versão em português (Imagem: Reprodução/New Voice)